Ответы на вопросы

Тут пока пусто...

...но мы ждем ваши вопросы

18 января 2024

Читать ~ 5 минут

Пока вы читаете эту статью, роботы поисковых систем уже осматривают тысячи веб-страниц в поиске новой информации. Но каким образом они знают, какие страницы сканировать, а какие нет? Ответ прост: файл robots.txt.

Robots.txt — это текстовый файл, который позволяет управлять тем, как поисковые роботы (или «пауки») взаимодействуют с вашим сайтом. Он буквально показывает поисковым системам, куда им можно лезть на вашем сайте, а куда категорически нельзя.

Файл robots.txt только кажется малозначительным текстовым документом в огромном объёме настроек сайта. На самом деле он играет решающую роль во взаимодействии веб-сайта с поисковыми роботами. Представьте его как указатели "Вход запрещен" или «Идти сюда!» для роботов поисковых систем, ищущих путь по цифровым дорогам. Но почему он настолько важен?

Поисковики ежесекундно систематизируют сайты и контент в интернете, чтобы выдавать из своего огромного «каталога» только самое подходящее под запрос пользователя. Файл robots.txt на сайте указывает им, какие разделы и страницы доступны для просмотра, а какие – запрещены. Это позволяет контролировать индексацию поисковыми системами, гарантируя, что конфиденциальный или избыточный контент остается скрытым от посторонних глаз.

Представьте, что ваш веб-сервер – это оживленная кухня, а каждый робот поисковой системы – голодный посетитель, делающий заказы. Файл robots.txt как официант для шеф-повара - позволяет вам определить, какие блюда (или веб-страницы) сервер должен подать первыми. Ограничив доступ поисковых роботов к ресурсоемким или временным файлам, вы можете снизить нагрузку на сервер.

Robots.txt позволяет исключить из индексации важные системные файлы, такие как файлы с паролями, конфигурационные файлы, временные кэши и т.д. Это важно для предотвращения несанкционированного доступа к системным ресурсам.

Теперь, когда вы понимаете значимость Проверка файла robots.txt на сайте – важная часть управления индексацией и защиты конфиденциальных данных. Давайте разберем, как можно выполнить эту проверку, чтобы удостовериться, что файл сконфигурирован правильно.

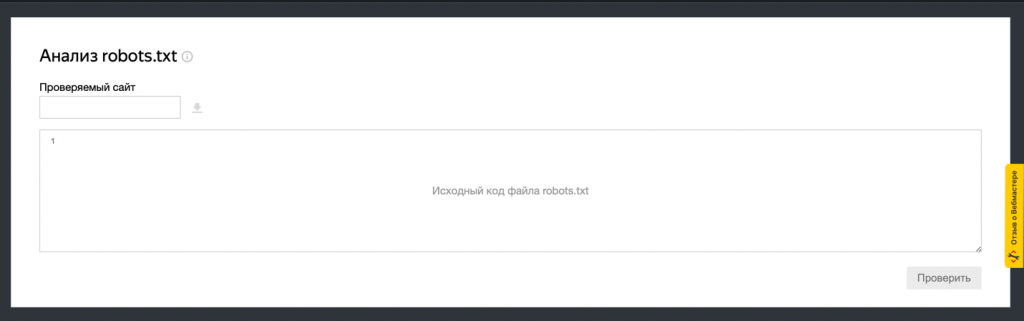

Существует множество бесплатных онлайн-сервисов, таких как «Google Search Console» и «Яндекс Вебмастер», которые позволяют вам проверить robots.txt на наличие ошибок или неправильно указанных директив. Просто скопируйте содержимое файла robots.txt в соответствующее поле на сайте инструмента и выполните проверку.

Вы можете проверить наличие robots.txt файл, просто добавив «/robots.txt» к адресу вашего сайта в адресной строке браузера (например, «https://mediamint.ru/robots.txt»). Если в итоге вы видите текстовый файл с какими-то запретами или директивами для ботов, значит, всё хорошо. А если там пусто или появляется ошибка, то что-то не так.

В интернете много онлайн-ресурсов, где можно быстро и бесплатно проверить файл robots.txt на ошибки. Например, Websiteplanet или PR-CY – достаточно ввести адрес сайта, и вы увидите всю нужную информацию о том, что нужно исправить.

Инструкции для поисковых систем в robors.txt называются директивами. Директивы в файле robots.txt определяют правила доступа для различных поисковых ботов к тем или иным разделам вашего сайта.

Эта директива определяет для какого поискового робота применяются последующие правила. Например, вы можете указать определенные инструкции для поисковых систем, таких как Googlebot или Яндекс, используя соответствующие идентификаторы User-agent.

Если в директиве стоит «*», то действуют общие правила для всех роботов.

Эта директива указывает поисковым роботам, какие части сайта им запрещено индексировать. Например, «Disallow: /private/» запрещает индексацию содержимого, находящегося в директории /private/.

Указывает, какие конкретные страницы или каталоги все же разрешены для индексации, даже если они находятся в директории, которая в целом заблокирована.

Например, если вы хотите запретить роботам индексировать каталог и используете директиву «Disallow: /catalog/», но при этом хотите, чтобы подраздел с дверями был в поиске, то добавьте в robots.txt директиву «Allow: /catalog/dveri».

Эта директива указывает задержку (в секундах), которую поисковые роботы должны соблюдать между запросами к серверу. Это может быть полезно для управления нагрузкой на сервер, особенно если у вас многостраничный сайт или ограниченные ресурсы сервера.

Хотя Sitemap.xml является предпочтительным способом предоставления информации поисковым системам о структуре вашего сайта, вы также можете указать путь к файлу Sitemap.xml в robots.txt с помощью директивы Sitemap. Например, «Sitemap: https://mediamint.ru/sitemap.xml».

Если у вас есть крупный сайт с множеством страниц, включая динамически генерируемые или редко посещаемые разделы, предоставление карты сайта через директиву «Sitemap» поможет поисковым роботам обнаружить эти страницы и индексировать их соответственно.

Файл robots.txt - своего рода «консьерж» вашего сайта, который определяет правила доступа для поисковых систем и других ботов. Правильно настроенный robots.txt может значительно улучшить индексацию сайта, обеспечивая баланс между доступностью контента и защитой конфиденциальных данных.

Однако, как показывает наша практика, даже крупные компании допускают ошибки при создании этого файла и теряют данные клиентов, а вместе с тем и репутацию. Важно не только понимать значение robots.txt, но и регулярно проверять его на правильность настройки с помощью специальных инструментов. Ведь в мире, где веб-трафик – валюта, а информация – ключевой ресурс, корректный robots.txt может стать вашим надежным союзником в сетевом пространстве!

Если вам нужна помощь в техническом анализе вашего сайта, звоните нам или пишите в WhatsApp – мы обязательно поможем. А чтобы не беспокоиться о надёжной работе своего сайта, закажите техническую поддержку и делегируйте заботу о сайте нашим специалистам.

Тут пока пусто...

...но мы ждем ваши вопросы